返回

搭建一个本地轻量级聊天 Ai

使用消费级电脑计算,并且不需要高端显卡

2023/07/21 14:53:53

标签: 人工智能

近年来 chatGPT 热度非常高,很多不同的大语言模型也破圈出现在大家的视野,如 科大讯飞星火、清华ChatGLM、百度文心一言、华为盘古大模型等。

这些语言模型服务一般都需要大公司服务器配置高端显卡来加速计算。使得普通用户上手门槛略高,不过好在他们也开放了一些量级相对小的模型。比如可以让最低拥有 6GB 显存的机器跑 ChatGLM-6B 量化后的模型,但这对于无独显的设备仍然是一个硬件门槛。

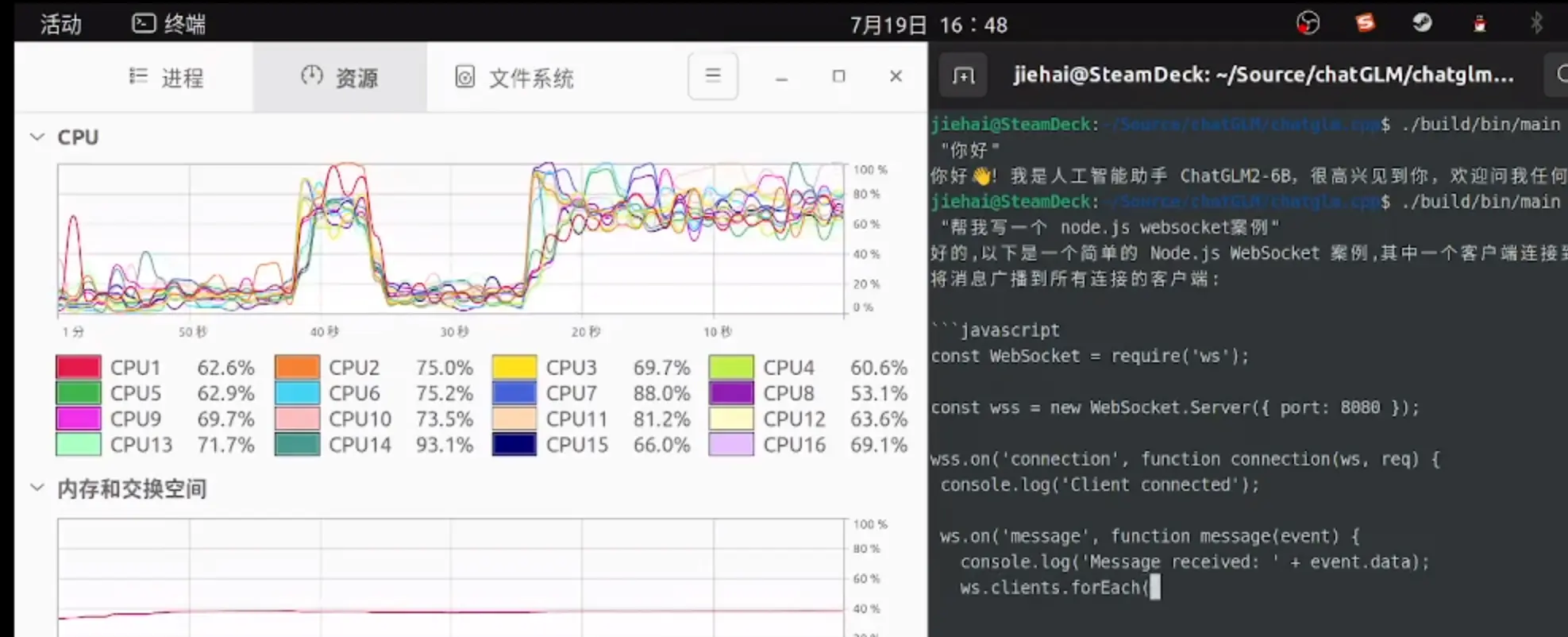

不过博主发现了一个Github项目,chatglm-cpp https://github.com/li-plus/chatglm.cpp 可以让我的 R7-6800h - 16GB 内存的笔记本跑起来该语言模型,它由C++ 实现。它提供了命令行 cli 和 web 端的展示前端

快速上手

这里以 Linux 系统为例,首先通过 git 克隆该项目的文件

git clone --recursive https://github.com/li-plus/chatglm.cpp.git && cd chatglm.cpp

默认你的电脑已经安装了 Python,cd 进入项目文件夹,通过以下命令将语言模型文件下载至本地

python3 convert.py -i THUDM/chatglm2-6b -t q4_0 -o chatglm2-ggml.bin

随后,使用 CMake 将项目编译构建

cmake -B build

cmake --build build -j

现在你就可以使用以下命令,来玩这个语言模型啦!👇

./build/bin/main -m chatglm2-ggml.bin -p "你好"

# 你好👋!我是人工智能助手 ChatGLM-6B,很高兴见到你,欢迎问我任何问题。

当然了,这个 chatGLM-6B 只是一个小模型,回答问题的准确率也比130B要低得多(但是可以玩一玩) 如果对 chatGLM 感兴趣可以去官网 https://chatglm.cn/detail 使用官方提供服务的版本。